Se ha publicado un interesante trabajo acerca de cómo almacena y procesa nuestro cerebro la información: si de forma discreta o continua. Se puede leer completo aquí: Is Information in the Brain Represented in Continuous or Discrete Form? Los autores explican por qué creen que sea muy difícil que las neuronas se comuniquen de forma continua –debido al exceso de ruido– y por qué la alternativa, que sea de forma discreta, es más plausible.

Para ello los investigadores de la Universidad de Canterbury en Nueva Zelanda prepararon varios modelos y realizaron tres experimentos cuyos resultados sugieren que el almacenamiento y procesamiento encaja mejor con un modelo discreto (con ciertos valores concretos) más que continuo (con todas las variaciones posibles en un intervalo).

Así por ejemplo en vez de una función continua de 0 a 15 con valores como 6,24… o 12,75… que varían poco a poco y pueden tener muchos decimales se guardarían sólo valores «redondos» como 0, 1, 2, 5, 10, 12, etcétera. En la práctica ambos métodos producen más o menos el mismo resultado – y se suelen convertir unos a otros según la necesidad, redondeando o recreando versiones continuas a partir de discretas.

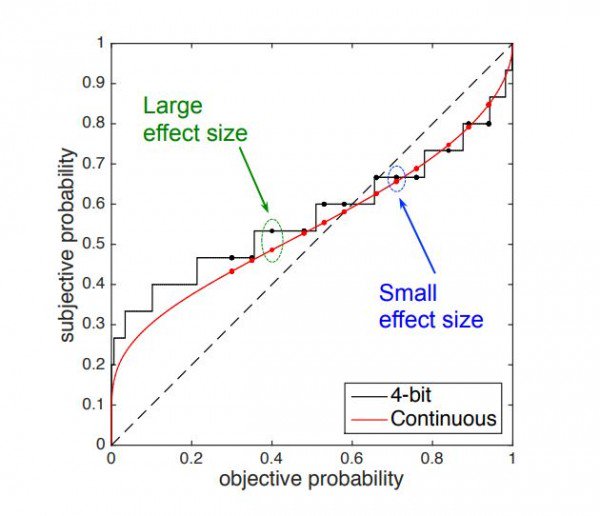

Algunos experimentos se realizaron en el campo de la probabilidad: los sujetos tenían que calcular la probabilidad de en qué sector de una ruleta caería la bolita. Tras 2.000 pruebas y diversas variaciones los resultados encajaban mejor con una «forma de procesar la información discreta» que con una analógica. También observaron que al valorar eventos temporales apenas había diferencias entre un periodo de, por ejemplo, 16 o 17 días.

Con toda esa información calcularon que la forma en que el cerebro cuantifica los cálculos probabilísticos es de 4 bits, que se correspondería a 16 valores distintos. Comparativamente en otros sistemas como el visual o el auditivo se trabajan con 24 o 16 bits, que es lo que se considera habitualmente la «resolución máxima» de dichos sistemas al fabricar pantallas o equipos de audio.

El trabajo es bastante reciente y probablemente será un tanto controvertido puesto que se desvía un tanto de lo que se venía considerado hasta ahora como más «natural»: que el cerebro funciona de forma suave con señales continuas, para pasar a ser algo que divide la información y las señales en algo más parecido a los bits y números enteros tan propios de las máquinas.

(Vía MIT Technology Review.)