Creo que dentro de 50 años será posible hacer que los ordenadores compitan en el juego de imitación tan bien como para que una persona promedio no tenga más del 70% de posibilidades de acertar tras 5 minutos de interrogatorio.

– Alan Turing (1950)

Si confiamos en la validez del archiconocido Test de Turing, una versión simplificada del juego de imitación original planteado por el pionero de la informática moderna, las máquinas no son a día de hoy tan «inteligentes» como nosotros los humanos y la humanidad sigue a salvo.

Al menos eso se deduce del que puede ser el mayor experimento online planteado sobre este ejercicio por varios expertos de AI21 Labs del que ya hablamos por aquí: ¿Ser humano o no? Los resultados están descritos en este trabajo: Human or Not? A Gamified Approach to the Turing Test [PDF]. Y es que el jueguecito lanzado a mediados de abril supuso que se llevaran a cabo más de 10 millones de tests de este tipo con personas de todo el mundo, online, comprobando si podían identificar correctamente a otros participantes o a inteligencias artificiales basadas en modelos de lenguaje LLM como GPT-4 y Jurassic-2.

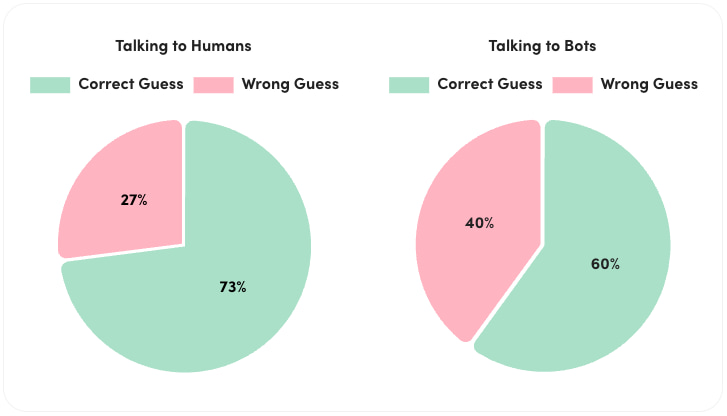

El resultado: cuando una persona hablaba con otra persona acertaban correctamente la identidad al otro lado del teclado el 73% de las veces (y fallaban un 27%); en cambio cuando hablaban con un bot sin saberlo acertaban el 60% de las veces y fallaban un 40%.

En el informe completo hay muchos más datos curiosos, como que los franceses, polacos y alemanes son quienes más aciertan (71%), mientras que los habitantes de la India, Rusia y España (!) somos los que menos (66%, ¡oooh!) Además de eso las mujeres aciertan ligerísimamente más veces que los hombres (67,7% frente a 67,4%) y los jóvenes más que las personas mayores (de más de 55 años).

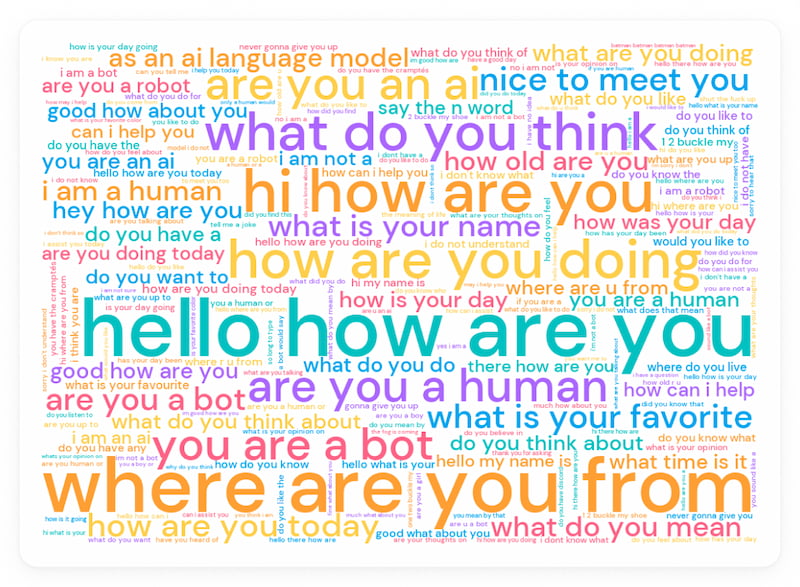

Las frases más populares que usó la gente en el experimento / A21Labs

El estudio está aderezado con la descripción de un montón de estrategias que usa la gente y pautas reconocibles, a cual muy curiosa. La gente, por ejemplo, da por hecho que los bots no cometen errores gramaticales ni escriben con erratas, palabrotas o jerga; también creen que los bots no saben mucho de temas actuales, o qué fecha/hora es. Curiosamente también identifican los buenos modales con ser «menos humano» e intentan usar juegos de palabras, trucos y preguntas personales para intentar «liar» a los bots.

Sea como sea, parece que todavía está lejos el momento en que se tornen los papeles y ese 40% de veces que la gente no puede identificar a los bots haciéndose pasar por personas llegue al 70% o más. ¿Un año? ¿Cinco? Quién sabe.

¿Y ChatGPT, qué opina de esto?

Pregunta: ¿Qué opinas de que según el experimento de A21Labs los modelos LLM como GPT-4 no puedan ser considerados todavía inteligentes porque sólo «engañan» al 40% de los seres humanos en el «juego de imitación» del Test de Turing?

ChatGPT-4: Como modelo de lenguaje AI, no tengo una opinión personal, pero puedo proporcionarte información objetiva sobre el tema que mencionas (…) Sin embargo, es importante tener en cuenta que el Test de Turing ha sido objeto de críticas y debate a lo largo de los años. Algunos argumentan que el Test de Turing es insuficiente para medir la inteligencia, ya que se basa principalmente en la capacidad de imitar respuestas humanas en lugar de evaluar un razonamiento verdaderamente inteligente (…) El hecho de que un modelo de lenguaje como GPT-4 no pueda engañar al 40% de los seres humanos en el Test de Turing puede ser una indicación de que aún hay margen de mejora en términos de su capacidad para imitar respuestas humanas de manera convincente. Sin embargo, la inteligencia artificial es un campo en constante evolución, y la evaluación de la inteligencia de los modelos AI debe considerar múltiples aspectos más allá del Test de Turing.

Relacionado:

- El test de Turing inverso

- Un Test de Turing mínimo en el que una sola palabra basta

- Demuestra que eres humano

- Superar el Test de Turing durante 10 minutos parece ser ya normal

- El Test de Turing

- Seis ordenadores intentarán pasar el Test de Turing

- Un diálogo visual de besugos: bots e inteligencia artificial

- Test Voight-Kampff para pobres

- El equivalente del test Voight-Kampff existe y se llama IAPS

- Sobre los animales (y otros seres) considerados conscientes