Mini World Of Bits es una idea para medir la «capacidad de aprendizaje» de agentes capaces de interactuar con sitios web y aprender mediante técnicas de refuerzo.

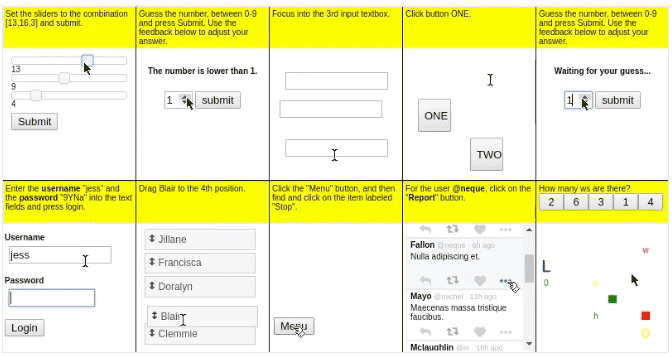

La idea consiste en estandarizar las pruebas de modo que los agentes reciben una pequeña pantalla con la tarea a realizar (zona en amarillo) y luego inteactúen con los formularios y páginas web: botones, menús, cajas de texto, gráficos, etcétera para superar las pruebas como lo haría un ser humano: un reto al estilo de los captchas que distinguen «humanos de robots». El resultado se valora entre 0,0 (fallo) y 1,0 (éxito) y también se tiene en cuenta el tiempo. Entonces se repite el proceso, cientos, miles o millones de veces si es necesario y en teoría el agente debería tender a mejorar, si acaso le es posible.

La idea de Andrej Karpathy, su creador, es que con esta batería de tests los desarrolladores puedan utilizar una colección más o menos estándar de pruebas contra la que chequear de forma genérica los agentes para resolver cualquier tipo de tarea, pudiendo compararlo con otros agentes y también con baterías de tests resueltos por humanos (cuyos resultados espera publicar en breve).

Todo esto forma parte de las iniciativas de OpenAI, un pequeño mundo virtual en el que se enfrentan inteligencias artificiales, sobre el que ya escribimos un artículo hace algunas semanas para la sección de tecnología de El País.

Como decían en @BitcraftLab, que es donde lo vi pasar: «Quizá fallar al resolver un captcha será pronto la única forma de demostrar que eres humano». ¿De qué me suena a mi eso?