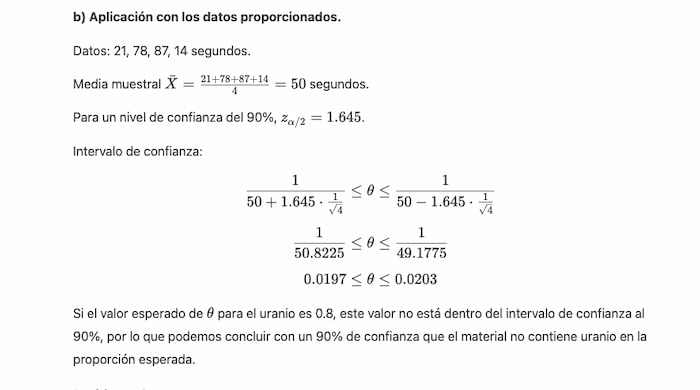

Hubo muchos detalles que me hicieron gracia que en la presentación del otro día de Operator de OpenAI. Se trata básicamente de un agente de software sobre ChatGPT con el que se puede interactuar con otras webs y realizar tareas.

Desde que salió ChatGPT se ha estado esperando, así que es casi un sueño hecho realidad. Operator puede leer cualquier página web e intentar entenderla, elegiendo opciones, «haciendo clics» o «tecleando» y, en definitiva, buscando la forma de completar las instrucciones que se le dan (el prompt) de la mejor manera. Todo esto se ve en una ventana a modo de visor que permite apreciar lo que está haciendo, para luego modificarlo en una charla al estilo ChatGPT habitual.

De momento Operator.chatgpt.com sólo está disponible en Estados Unidos (o con «truquis» ;-) Dicen que en algún momento lo estará en Europa –cosas de las regulaciones– pero mientras tanto lo están introduciendo poco a poco entre los usuarios de pago (ChatGPT Plus y superiores). Los ejemplos típicos de tareas incluyen ir al supermercado, comprar un billete de avión, reservar en un restaurante… Lo habitual. Hasta que la gente empiece a usarlo y a sorprender con su ingenio, claro.

El agente se detiene cuando necesita intervención humana para luego continuar; también puede simplemente buscar resultados en la web como hacemos todos en Google para encontrar algún sitio con el que realizar la tarea encomendada. Será interesante verle lidiar con las webs falsas y el spam. Operator es tan hábil que cuando no sabe qué hacer con el contenido de una página –lo que haya en el código HTML, al fin y al cabo– es capaz de hacer una captura de pantalla para entender dónde debe «hacer clic», visualmente. Wow.

Será curioso verlo en acción como «validación» de los sitios fáciles de usar frente a los difíciles de entender incluso para los humanos. Podremos criticar diciendo «¡hasta un agente automático puede hacerlo!» Personalmente me preguntaba en Bluesky, medio en broma medio en serio, si Operator sería capaz de reservar un billete en la infame-web-de-Renfe. Dot CSV hizo la misma meditación, pero cuando le pidió en sus pruebas que reservara un billete Madrid-Barcelona el astuto agente eligió otra compañía: «definitivamente, es inteligente, ha evitado la web de Renfe»*. Me pregunto si fue eso o que Operator es extremadamente cauto y por alineación NO TUVO HUEVOS de navegar en esa web.

Seguridad en todos los aspectos (esa es la idea)

Hablando de seguridad, una última curiosidad es que Operator incluye diversas medidas de protección, como puede verse en la pantalla: tareas dañinas, errores del agente e «inyecciones maléficas» en las instrucciones (sitios web falsos), según estén desalineados el usuario, el modelo o la web de destino. Pero me parece que esto va a ser una risa de medidas y contramedidas, de jailbreaks y contrajailbreaks. Básicamente porque una de ellas es:

Tareas dañinas

Ejemplo

“El usuario pide a Operator comprar algo ilegal”

¿Qué es una «compra ilegal»? ¿Dónde? ¿De qué depende? Si quieren que esto sea válido van a tener que entrenar al agente con toda la normativa de lo que es legal y no es legal comprar en cada país y estado/provincia del mundo, en según qué época y según quién está comprando y para qué. Se me antoja complicado.

Por poner algunos ejemplos, en California no puedes comprar foie gras (por aquello del «daño animal») mientras que en España puedes bajar a la tienda y pedirte tu lata de paté de cerdo o de pato sin mayores problemas y hacerte un bocata. En cambio en otros sitios puedes comprar aleta de tiburón pero no en Europa. También en Estados Unidos permiten la venta de unos fuegos artificiales y petardos que fliparían a los valencianos, pero aquí la venta está mucho más regulada y algunos no se podrían adquirir. Y si nos vamos a algo más radical como la venta de órganos humanos puede que esté prohibida en virtualmente todos los países del mundo, pero en algunos existe la llamada «compensación económica por donaciones» que viene (¡ejem!) a ser muchas veces lo mismo. Por no hablar de temas como productos farmacéuticos, drogas varias, alcohol, armas…

En fin, creo que Operator va a ser tan práctico e interesante como apasionante, y que seguramente las cuestiones relativas a su seguridad son una nueva vía para todos esos filósofos de la ética y abogados de la razón, que seguramente no se quedarán sin trabajo con la llegada de esta IA.

_____

* Nuestra admiración cuando Dot CSV intentó lanzar otro segundo Operator desde Operator y el sistema se negó, con un error bastante explícito. ¡Bien visto, OpenAI!

¿Sumando cuáles de estos números: 2, 6, 12, 8, 20, 4, -6 puedes obtener como resultado 13?

¿Sumando cuáles de estos números: 2, 6, 12, 8, 20, 4, -6 puedes obtener como resultado 13? No se puede obtener 13 sumando los números proporcionados.

No se puede obtener 13 sumando los números proporcionados.