Por Nacho Palou —

En Labsix, Fooling Neural Networks in the Physical World with 3D Adversarial Objects,

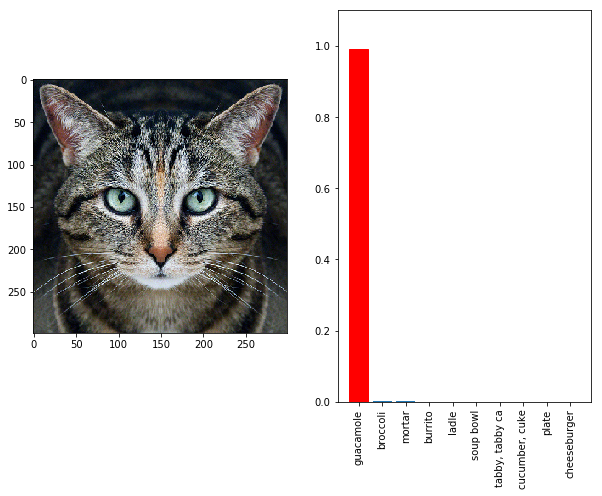

Los métodos de identificación basados en redes neuronales logran un rendimiento casi humano en muchas tareas, y en la práctica se utilizan en sistemas de alto riesgo. Sin embargo, estas mismas redes neuronales son particularmente vulnerables a “muestras conflictivas” que son capaces de provocar errores en la identificación. Un ejemplo es el gato Tabby (abajo), que el clasificador de imágenes InceptionV3 de Google confunde con guacamole o la tortuga impresa en 3D que el sistema identifica como una arma (un rifle) desde cualquier de sus ángulos.

En The Verge, Google’s AI thinks this turtle looks like a gun, which is a problem,

En el mundo de la inteligencia artificial (IA), las “muestras adversariales” son imágenes diseñadas para engañar el software de visión artificial, incorporando patrones especiales que hacen que los sistemas de IA se vuelvan locos. Son como ilusiones ópticas para ordenadores. Se pueden diseñar gafas adversariales que engañan a los sistemas de reconocimiento facial y lo incapacite para reconocer a alguien, o aplicar un patrón contradictorio a una imagen que la haga “invisible” ante la IA. Aunque los humanos no notarían la diferencia para un ordenador puede suponer que un animal de repente se ha convertido en una camioneta.

En la práctica los ataques adversariales no suponen un gran riesgo, por ahora, ya que “aunque efectivos lo son en circunstancias muy concretas. El problema es que demuestran lo frágiles que pueden ser los sistema de inteligencia artificial.”

Relacionado,