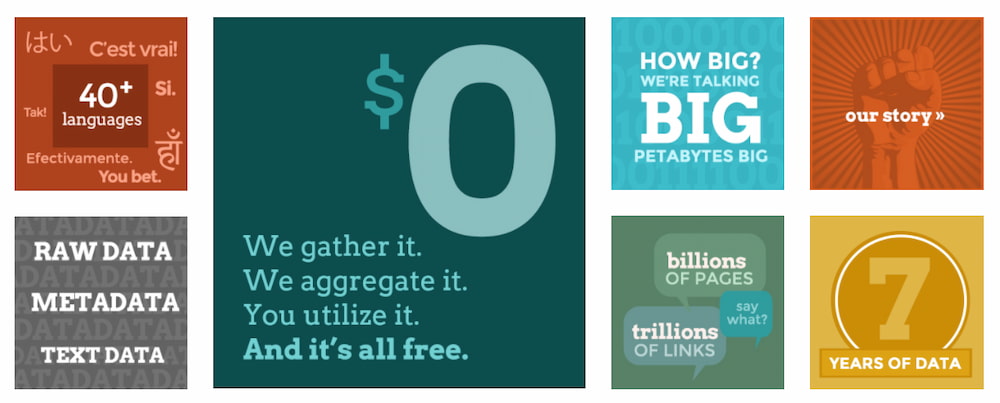

El nombre de Common Crawl es a la vez un proyecto y una organización sin ánimo de lucro que desde 2011 se dedica a rastrear la World Wide Web y generar un archivo abierto y accesible para que cualquier persona o empresa pueda acceder a una copia completa cómodamente y sin tener que pagar nada… algo así como lo mismo que tienen Google, Bing y el resto de buscadores, pero en versión de los comunes de los mortales. Según cuentan en su blog la última versión ocupa 280 terabytes y contiene 2.700 millones de páginas. Buenas cifras; inmensas pero no inabarcables.

Entre los proyectos ya llevados a cabo con estos datos están:

- Análisis de popularidad de dominios

- Extracción de ofertas de empleo

- Pruebas de categorización

- Análisis sobre la publicidad en internet

- Búsqueda de tags

- Reconocimiento de sitios que publican feeds RSS

- Análisis del impacto de noticias en los mercados

- … y decenas de otros

El proyecto técnicamente utiliza un bot llamado CCBot que está basado en Nutch, de Apache. Se comporta como cualquier otro bot y cualquier webmaster pueden utilizar el protocolo robots.txt de exclusión de robots, si quiere evitar que indexe sus páginas o que lo haga más despacio (ver FAQ). El rastreo es automático y se realiza periódicamente, según parece al menos una vez al mes. Aunque no lo he visto específicamente indicado da la impresión de que sólo extrae el texto de las páginas, no las imágenes ni vídeos, que sin duda ocuparían mucho más.

Por que he cotilleado por ahí el número promedio de hiperenlaces por página web debe estar alrededor de los 35 enlaces, de modo que esto significa que en el último rastreo debía haber en la WWW alrededor de 100.000 millones de enlaces en toda la Web que han podido rastrear. Bonita cifra.

Relacionado:

- Las ciudades perdidas de GeoCities y su rescate

- Los enlaces que mueren y la Web que desaparece página a página

- El crecimiento del Archivo de Internet durante 2020

- The Internet Archive ya ha alcanzado los 90 petabytes y sigue creciendo

- YTMND resurge de sus cenizas y vuelve a traer el humor a internet