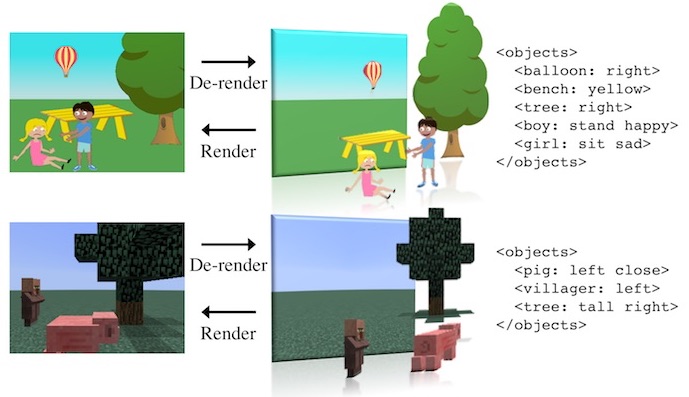

En el laboratorio de inteligencia artificial del MIT trabajan en algo llamado Neural Scene De-rendering («Desrenderizado de escenas mediante técnicas neuronales»). Básicamente consiste en obtener información de los objetos y lo que sucede en un fotograma 2D o una animación para lograr lo que llaman un entendimiento holístico de la escena. El resultado es, dicho de forma simple, un texto XML que describe los objetos, categorías, poses y posiciones que ocupan.

Aunque esto sea algo trivial para los humanos para un sistema de reconocimiento visual no tiene nada de fácil. Normalmente las imágenes que se reciben están en 2D, aunque a veces puedan utilizarse dos o más cámaras o un LIDAR o similar para recrear un entorno 3D (por ejemplo en el caso de los coches autónomos). Mientras que nuestro cerebro tiene unos filtros estupendos para hacernos entender lo que no vemos y comprender más allá de lo aparente lo que está sucediendo, una inteligencia artificial no tiene en principio nada de eso.

El sistema se llama así porque en el software se fuerza a realizar la operación inversa a la renderización habitual de las escenas 3D: una «desrenderización». Pero resulta que esa operación es computacionalmente muy compleja, de ahí que se utilicen redes neuronales para ello.

En las pruebas han utilizado mundos de Minecraft y los paisajes y habitantes habituales de ese entorno (campesinos, cerdos, árboles…) y también películas sencillas con dinámicas físicas para intentar que el sistema sea capaz de explicar lo que sucede en el vídeo. Por lo que se ve en los ejemplos, aciertan bastante bien.