Who’s to blame when a machine botches your surgery? en Quartz es un buen artículo que explora las connotaciones éticas y legales de la «responsabilidad» de las inteligencias artificiales aplicadas a la medicina.

Si un robot realiza una cirugía y algo sale mal, ¿de quién es la culpa? ¿Del fabricante del robot? ¿De la persona que programó y revisó el código? ¿De los médicos que lo supervisaban? ¿De nadie? La cuestión lleva naturalmente a más preguntas que respuestas, puesto que en gran parte es algo en lo que jueces y tribunales no han intervenido mucho hasta ahora.

No se trata de una discusión abstracta. Definir la responsabilidad ética y legal en el mundo de la atención médica es vital para construir la confianza de los pacientes en la profesión y sus estándares. También es esencial para determinar cómo compensar a quienes sufren errores médicos.

El artículo explica que en cierto modo un robot cirujano o una inteligencia artificial que plantea un tratamiento pueden no ser muy diferentes de los cinturones de seguridad de un coche: normalmente si alguien muere en un accidente, los cinturones no son el problema, ni el fabricante del vehículo tiene la culpa… A menos que se pueda demostrar que tenían un fallo de diseño, instalación o revisión y que eso fuera decisivo en el devenir del accidente en cuestión. Teniendo en cuenta que actualmente las IA no explican demasiado por qué hacen lo que hacen la situación se complica un poco más en este caso.

De momento por lo general se considera que una IA debe estar siempre supervisada por un médico, de modo que lo que hace es más una recomendación que una actuación. En caso de problemas cada situación acabará probablemente con un «depende»: porque podría suceder lo mismo que si el médico hubiera trabajado con instrumental defectuoso o bien que fuera un fallo de criterio suyo al aceptar una recomendación errónea o confiar en una máquina más allá de lo razonable. El tema en cualquier caso sigue encima de la mesa.

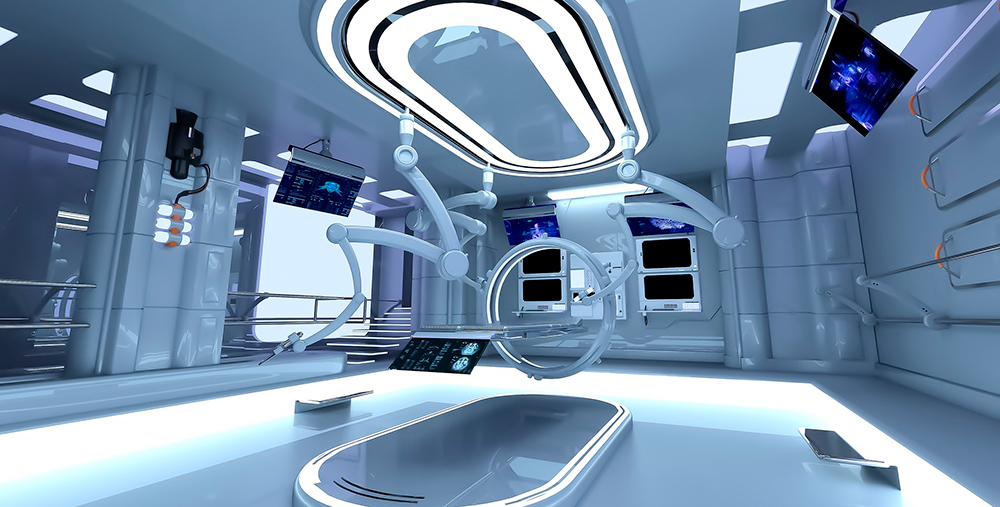

{Foto: Alan9187 @ Pixabay.}