La red neuronal de Google que puede saber dónde se tomó una foto sólo con mirarla, sin los datos GPS

En MIT Technology Review, Google Unveils Neural Network with “Superhuman” Ability to Determine the Location of Almost Any Image,

Tobias Weyand, especialista en visión artificial en Google y un par de sus colegas han desarrollado un software capaz de determinar dónde fue tomada una foto utilizando sólo los píxeles que contiene, sin necesitar los datos GPS de la fotografía (...) su máquina ya supera a los humanos en esa tarea, e incluso llega a determinar la ubicación de fotografías de interiores y de objetos como mascotas o alimentos, imágenes sin pistas sobre la localización.

La tarea de reconocer dónde se hizo una foto puede ser muy fácil si en la foto aparece, por ejemplo, un momento o accidente geográfico reconocible –la Torre Eiffel, el Monte Rushmore,— o muy complicado e incluso (de entrada) imposible cuando se trata de una foto de un plato de lentejas.

Los humanos podemos jugar a adivinar el dónde ayudándonos por pistas como el aspecto o idioma de las señales o indicaciones, el tipo de arquitectura o de vestimenta, el lado por el que circulan los coches,... Incluso gente que haya viajado mucho puede reconocer lugares por el ambiente o el entorno. O porque ha estado allí.

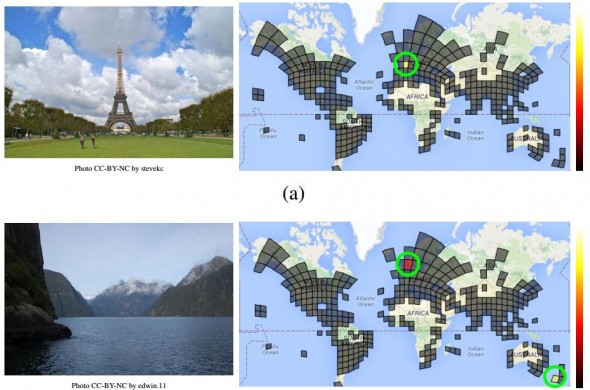

Para entrenar a su hurón ordenador Weyand y sus colegas alimentaron su red neuronal, a la que han bautizado como PlaNet, con millones de fotografías. 126 millones de fotografías taggeadas con sus coordenadas GPS situadas en un mapa del mundo dividido por una cuadrícula.

La máquina aprende de este modo a qué recuadro de la cuadrícula corresponde cada foto, primero por los datos GPS que acompañan a la foto y después reconociendo los píxeles de la foto — sin “mirar” los datos GPS.

Según Weyand y su equipo la máquina es capaz de reconocer otras fotos que se añadan, a distintos niveles: en qué calle se tomaron (3,6% de aciertos) en qué ciudad (10,1% de aciertos) en qué país (28,4%) y en qué continente (48%).

Como demostración, PlaNet compitió con un grupo de humanos viajados y ganó. El software fue capaz de reconocer 28 de los 50 lugares presentados en fotografías con un margen de error en la localización de 1132 km. El margen de error de los humanos fue de 2320 km. La explicación es “simple”: por mucho que hayan viajado los humanos rivales, la máquina ha visto más mundo que todos ellos juntos — aunque haya sido sólo en fotos.

Yendo un paso más allá, la máquina puede llegar a determinar la localización de una fotografía tomada en interiores o en la que sólo se ve un plato de un comida. El truco de la máquina es que guarda registro de cómo se relacionen las fotos entre sí, de modo que si la foto de un objeto pertenece a un álbum y ambas fotos se tomaron más o menos consecutivas, la máquina puede usar otras fotos para determinar dónde se hicieron y trasladar ese dato a la foto del plato de comida.

Y por si todo lo anterior no fuera suficiente, «el software ocupa 380 MB, cabe en un teléfono móvil.»