Uno de los retos pendientes de la inteligencia artificial es un aspecto del que pocas veces se habla. A veces nos maravillamos por lo bien que funciona, por cómo toma decisiones o resuelve problemas pero pocas veces nos planteamos por qué hace lo que hace o sabe lo que sabe.

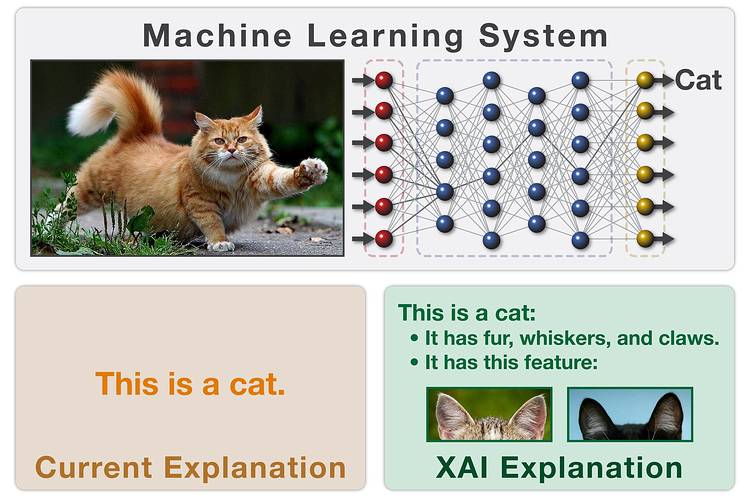

Por esta razón un proyecto de DARPA está intentando crear algoritmos capaces de explicar por qué toman sus decisiones. Lo llaman ingeligencia artificial explicable. Un centenar de investigadores están en ello y aunque el ejemplo del reconocimiento de la figura de un gato pueda parecer un tanto trivial, el asunto se complica cuando hay que justificar una decisión médica o de negocios – por no hablar de cuando la Skynet de turno decida atacar países o acabar con vidas humanas, que todo llegará.

El proyecto de momento se centra en los sistemas y algoritmos de aprendizaje automático (machine learning) que son en cierto modo los que aprenden de una forma más peculiar y cuyos «motivos» pueden resultados más insólitos. En el artículo del Wall Street Journal Inside Darpa’s Push to Make Artificial Intelligence Explain Itself ($) se entrevista a diversos expertos, que explican cómo funcionan algunos de estos algoritmos y lo que se puede esperar de ellos.

En cierto modo es como esa sensación que tienes cuando un software que has escrito de repente empieza a hacer cosas raras y mejores de lo que te habías planteado en un principio. Sólo puedes entenderlo si lo examinas concienzudamente y trazas los estados y variables que llevan a los resultados. Pues esto puede ser algo así pero a lo bestia.

Con el aprendizaje automático el problema es que prácticamente el propio aprendizaje es el programa, de modo que esas razones –que puede que tengan cierta lógica o, quién sabe, quizá no tanta– quedan mucho más escondidas todavía. Así que mejor para todos si los programas son capaces de explicarse a sí mismos. Eso sí: ¡mientras no nos engañen!

§

Véase también: What does the “we don’t understand how artificial intelligence takes decisions” statement mean? en Mapping Ignorance, sobre el teorema de aproximación universal en las redes neuronales artificiales.