Cruce de cables 32 (12 de abril de 2025)

Mis soluciones de baja tecnología favoritas [~18:20] – En este Cruce de Cables rememoramos cinco de mis «soluciones de baja tecnología» favoritas, esas soluciones para problemas cotidianos usando «tecnología primitiva», totalmente básica. Entre ellas:

Mis soluciones de baja tecnología favoritas [~18:20] – En este Cruce de Cables rememoramos cinco de mis «soluciones de baja tecnología» favoritas, esas soluciones para problemas cotidianos usando «tecnología primitiva», totalmente básica. Entre ellas:

- Cómo arreglar la pestaña de plástico de un conector Ethernet RJ-45 estropeada… con un palillo.

- Cómo guardar fácilmente todos los números de serie de aparatos y gadgets, para el seguro de la casa.

- Cómo usar la cabeza como antena amplificadora con el mando del coche para encontrarlo en el aparcamiento, abrirlo o cerrarlo.

- Cómo identificar los auriculares izquierdo y derecho mediante un simple nudo, para saber cuál es cuál incluso en la oscuridad.

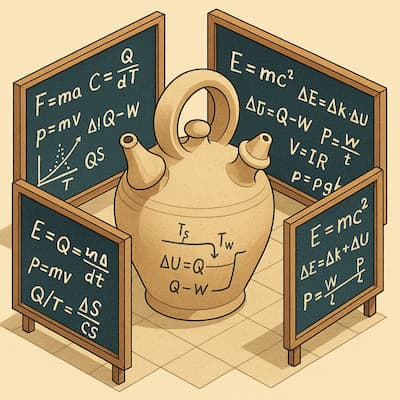

- El El botijo. En los 90 los profesores Pinto y Zubizarreta desarrollaron la ecuación del botijo con 16 factores: volumen de agua, temperatura, coeficiente de radiación de calor, superficie total del botijo… Pura física y fórmulas matemáticas.

_____

Cada semana grabamos con David Sierra en el distendido ambiente de Cruce de Cables, el programa de Radio Nacional de España, como colaboradores habituales. Se emite en RNE los sábados de 03:00 a 04:00.

Relacionado:

- Cruce de cables: Los 50 años de Microsoft

- Cruce de cables: ¿Por qué son tan malas las IAs jugando al ajedrez?

- Cruce de cables: Los hackers no son piratas informáticos

- Cruce de cables: El seguimiento de famosos a través de GPS

- Cruce de cables: Los astronautas no abandonados en la EEI

- Cruce de cables: Aviones de pasajeros supersónicos de ayer y hoy

- Cruce de cables: La primera Ley de inteligencia artificial

- Cruce de cables: ¿Un nuevo invierno de la inteligencia artificial?

- Cruce de cables: Tecnología y las armas nucleares casi la lían parda.

- Cruce de cables: Zuckerberg y sus movimientos con los verificadores

- Cruce de cables: Las chicas del ENIAC y de los Colossus

- Cruce de cables: La reparación de un ordenador a válvulas de los 50

- Cruce de cables: El legado digital

- Cruce de cables: Ada Lovelace y Grace Murray H. Hopper, informáticas

- Cruce de cables: La evolución de ChatGPT, la IA generativa más popular

- Cruce de cables: No vemos robots repartidores por las calles

- Cruce de cables: Cómo no quedarse desconectado en una emergencia

- Microsiervos como colaboradores de Cruce de cables de RNE