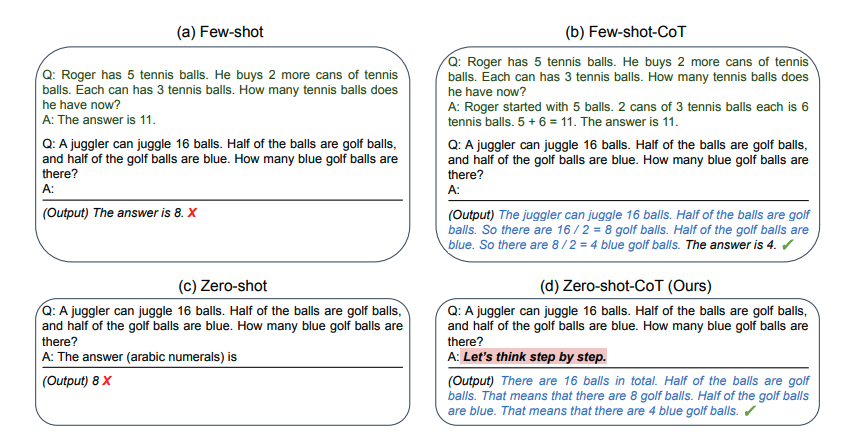

Bajo el título Large Language Models are Zero-Shot Reasoners hay un profundo trabajo sobre IA en el que se explica uno de los problemas de los modelos de procesamiento lenguaje natural. Resulta que esos algoritmos, como el archifamoso GPT-3 de Google, a veces no son capaces de razonar de forma efectiva incluso en cuestiones aparentemente sencillas, como las de problemas aritméticos que resolverían alumnos de primaria.

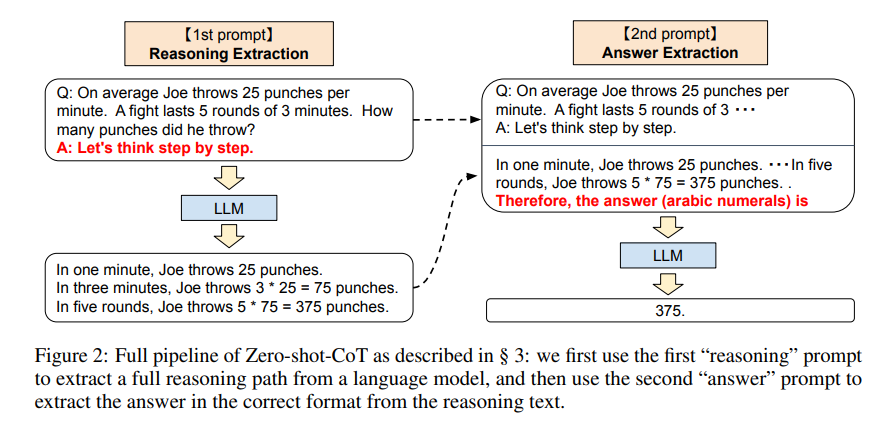

Pero lo mejor del asunto es la solución. Tan obvia y simplona que resulta asombroso que se hubiera pasado por alto hasta ahora. Añadir frases como «vamos a razonar paso a paso» a los enunciados, para forzar a esos sistemas a utilizar la lógica, a ser realistas o a «pensar como detectives».

Para probar este tipo de algoritmos se utilizan unos benchmarks o tests de referencia como son el MultiArith o el GSM8K. Básicamente, los investigadores enfrentan su algoritmo a todas la batería de preguntas y se anota la puntuación. Toqueteando algunos parámetros o cambiando el algoritmo se puede hacer que mejore o, si el resultado empeora, tirarlo a la basura. Quizá fue una sorpresa que al añadir las frases en cuestión como comienzo de las respuestas, todo mejorara mágicamente. Entre ellas están todas estas:

#1 Pensemos paso a paso.

#2 Primero,

#3 Pensemos esto con lógica.

#4 Resolvamos el problema dividiéndolo en pasos.

#5 Seamos realistas y pensemos paso a paso.

#6 Pensemos como un detective, paso a paso.

#7 Pensemos.

#8 Antes de adentrarnos en la respuesta,

#9 La respuesta va a continuación de la prueba.

Todos estos trucos de la abuela mejoran la precisión entre los 45,7 y los 78,8 puntos en alguna de las pruebas. Teniendo en cuenta que si no se utiliza ningún texto de ayuda la puntuación típica son 17,7 puntos… ¡Vaya diferencia! El simple hecho de sugerir al algoritmo a que puede dar la respuesta dividiendo el problema en varios pasos, o a que ponga más peso en el razonamiento lógico parece mejorar notablemente los resultados.

Esta especie de conocimiento oculto de las IAs en general (no creo que sea de GPT-3 en particular) es algo que merece la pena explorar, y explotar. En el propio trabajo se sugieren algunas ideas, que ha ampliado la colmena de Twitter, como sugerir al algoritmo dar la respuesta en numerales arábigos, utilizar términos más o menos técnicos según el nivel de los problemas (ej. «pensemos» para razonamientos infantiles, «considérese» para trabajos formales y similares) u otras más rebuscadas como «La forma de resolver el problema es…»

Visto lo visto, quizá eso de que en el futuro habrá puestos de trabajo consistentes en entrenadores y descubridores de trucos y sutilezas lógicas para hacer que las IAs funcionen mejor no va a ser ninguna tontería.

Relacionado:

- La curiosa historia sobre cómo un simple plátano acabó siendo la respuesta perfecta a un Test de Turing

- Copilot de GitHub, un ayudante entrenado mediante IA para completar y escribir código de programación

- DALL·E es una inteligencia artificial que crea imágenes a partir de descripciones en lenguaje natural

- «Crear un chatbot que conversa como una persona específica», una patente solicitada por Microsoft

- Enigma GPT-2: ¿Puedes distinguir un artículo real de otro falso generado mediante inteligencia artificial simplemente leyendo el resumen?