Unos investigadores del Instituto Allen de Inteligencia Artificial de Seattle (Washington, EE.UU.) han desarrollado en los últimos años una inteligencia artificial llamada Aristo que es capaz –con un poco de truqui– de aprobar con sobresalientes (al menos el 90% de las veces) los exámenes de ciencia para jóvenes de 13-14 años y también al 83% en los equivalentes para 17-18 años.

Son preguntas del estilo:

P: ¿Qué forma de energía se produce cuando vibra una goma elástica? (A) Química (B) Luz (C) Eléctrica (D) Sonido.

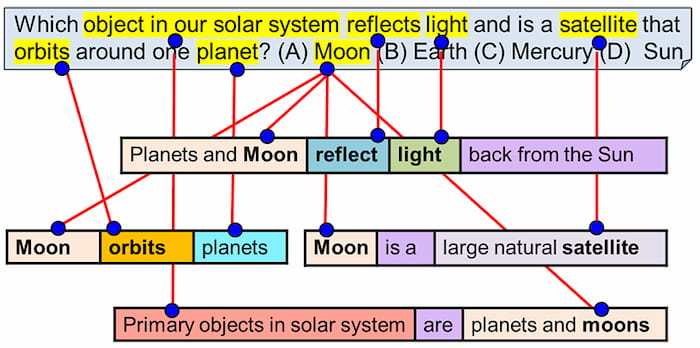

Estos exámenes –han usado el denominado New York Regents Science Exam, una prueba estándar en el estado de Nueva York– son de tipo test (A-B-C-D). La inteligencia artificial estaba entrenada para entender los enunciados y a partir de ahí elegir la respuesta más probable; la principal diferencia era que este software no sirve para los problemas con diagramas (lo cual es una limitación importante, pero supongo que todo se andará).

Según cuentan en el trabajo –conviene leérselo completo para entender las sutilezas; Vox Media tiene un buen resumen– hay una gran diferencia entre esta prueba y un Test de Turing. Lo que se busca aquí no es crear una inteligencia artificial de ámbito general que se haga pasar por una persona, ni tampoco «memorizar libros de texto». La idea es que Aristo entendiera el lenguaje natural mediante métodos como acceder a un gran corpus de información y la aplicación de modelos estadísticos.

Los traductores automáticos funcionan hoy en día en parte mediante estos sistemas. El resumen es que Aristo es muy bueno haciendo algo muy concreto –exámenes de ciencias– pero no es tan inteligente –ni de lejos– como un estudiante de secundaria. Wired lo explica diciendo que «aunque apruebe exámenes para jóvenes de 18 años no pasaría las pruebas de parvulario».

Incluso si la nota del 90% parece poco hay que tener en cuenta que en 2016 el mejor sistema tan solo puntuaba con un 59%. IBM también demostró hace años también una importante capacidad haciendo que su sistema Watson ganara jugando al Jeopardy –tan complicado o incluso más que estos exámenes– e incluso ganando en otros problemas más abiertos como los «debates dialécticos» con su Project Debater.