En Helping AI master video understanding el investigador de IBM Research AI, Dan Gutfreund, cuenta un poco cómo el uso del vídeo está acelerando el desarrollo de tecnologías y modelos que proporcionan “comprensión” automática a la inteligencia artificial.

Utilizando un repositorio de un millón de clips de vídeos, de tres segundos de duración cada uno, las redes neuronales son capaces de predecir qué va a suceder o qué está sucediendo en los vídeos. También “desarrollan la habilidad” de aprender qué partes del vídeo son las más importantes de cara a identificad momentos de la vida cotidiana.

Durante décadas los investigadores en el campo de la visión artificial han intentando desarrollar modelos de comprensión visual que se asemejen al nivel de los humanos. Sólo en los últimos años y gracias a los avances en el aprendizaje automático hemos comenzado a desarrollar modelos que están a la altura del rendimiento humano, aunque de momento se limitan a un puñado de tareas y a ciertos conjuntos de datos.Este logro se debe fundamentalmente a dos factores: los conjuntos de datos etiquetados masivamente y las mejoras significativas en la capacidad de los ordenadores, que permiten procesar grandes conjuntos de datos con millones de parámetros en tiempos razonables.

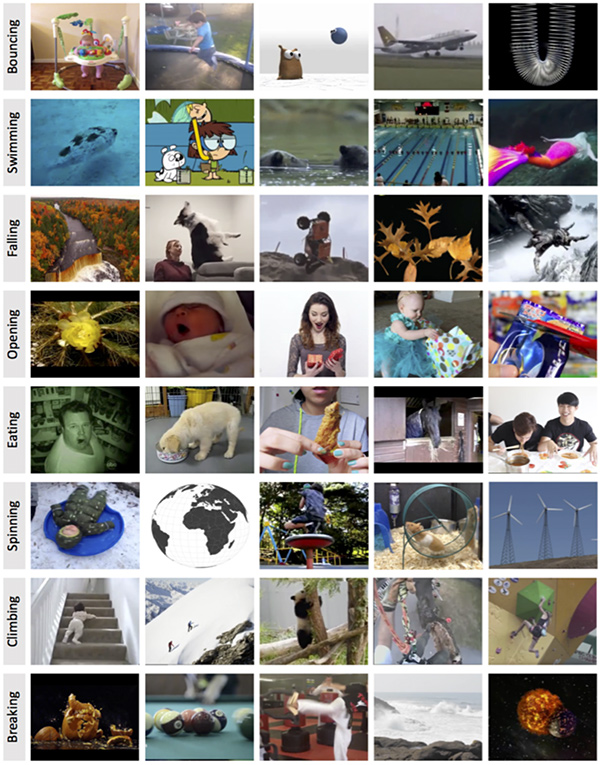

El conjunto de datos, recopilados en Moments in Time Dataset, hace uso de clips de vídeo públicos que recogen momentos cotidianos en los que aparecen personas, animales, objetos y fenómenos naturales. El proyecto se basa en identificar qué sucede en esos clips etiquetándolos con palabras que describen las acciones básicas con términos como “saltar”, “hablar”, “cocinar”, “caer”... Y a partir de ahí una red neuronal “aprende” a identificar y reconocer escenas. En algunos casos los vídeos no muestran la acción, pero el audio permite identificarla (por ejemplo, “aplaudir”), algo que al añadirlo “permite el desarrollo de modelos multimodales para el reconocimiento de acciones,” según los investigadores del MIT IBM Watson AI Lab.

La comprensión automática de video ya juega un papel importante en nuestras vidas, y creemos que el número de aplicaciones crecerá exponencialmente en ámbitos como la asistencia a los discapacitados visuales, el cuidado de ancianos, la automoción o los medios de comunicación y de entretenimiento, entre otros muchos.

IBM ofrece acceso libre al conjunto de datos Moments in Time con fines educativos y de investigación, con el fin de fomentar nuevos estudios y desarrollos que aceleren los avances en inteligencia y visión artificial.