Aunque James S.A. Corey dejó (¿dejaron?) bastante atado el arco principal de la historia de The Expanse quienes nos enamoramos de ese universo siempre queremos más. Y ahora nuestros deseos se cumplen con una nueva dosis en la forma de A Little Death.

Se trata de una historia situada en esos 30 años que pasan entre el final de la serie y el principio de El alzamiento de Persépolis, la séptima novela de la serie:

A raíz de las repercusiones de lo ocurrido en The Expanse: Dragon Tooth, la tripulación de la Rocinante se ve inmersa en una conspiración de alto riesgo cuando un viejo conocido de Amos Burton acude a él en busca de ayuda.

Cuenta con la supervisión de James S.A. Corey, así que la historia es canon en el universo de la serie, que diverge ligeramente del de los libros. Tiene el interés extra de que Wes Chatham, el actor que interpreta a Amos Burton, ha estado involucrado en su escritura.

Está contada en formato cómic. Puedes escoger si quieres los cuatro cómics sueltos en PDF, en papel, en un sólo tomo. Y como han conseguido superar con creces la financiación que necesitaban, escojas la opción que escojas, vendrá con algunos extras.

Eso sí, si compras los cómics a través de esta campaña tendrás ediciones limitadas con portadas distintas a las que luego puedan salir a la venta a través de canales tradicionales.

(Vía The Spaceshipper).

Tras la aprobación ayer por parte del Consejo de Ministros del real decreto que lo regula desde hoy en España ya puedes

Tras la aprobación ayer por parte del Consejo de Ministros del real decreto que lo regula desde hoy en España ya puedes

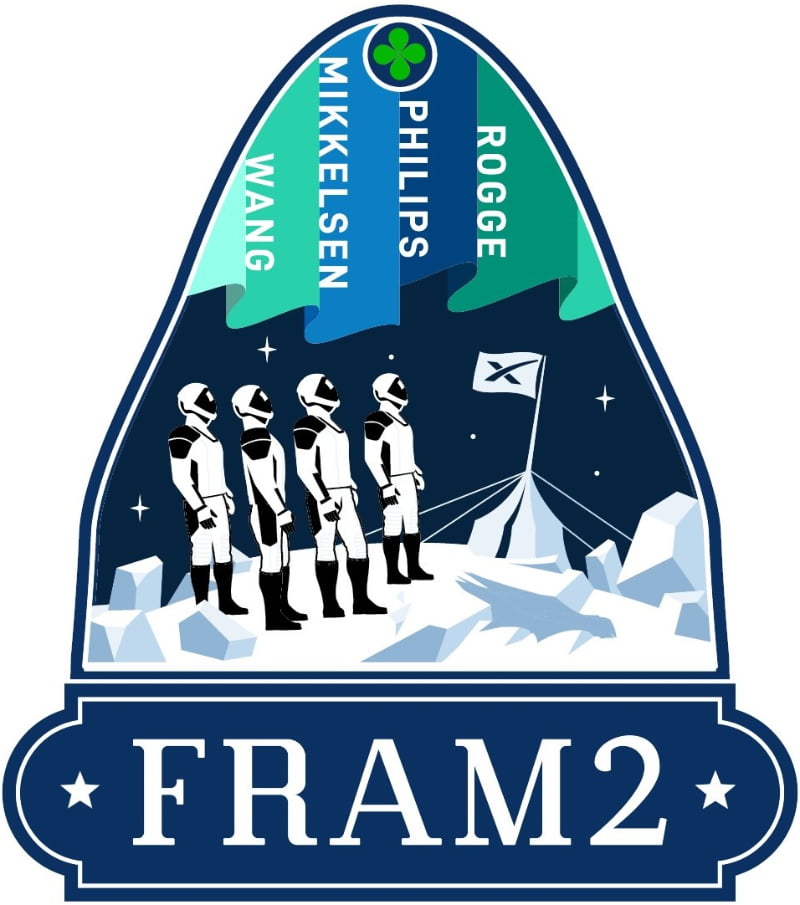

El nombre de la misión rinde homenaje al

El nombre de la misión rinde homenaje al